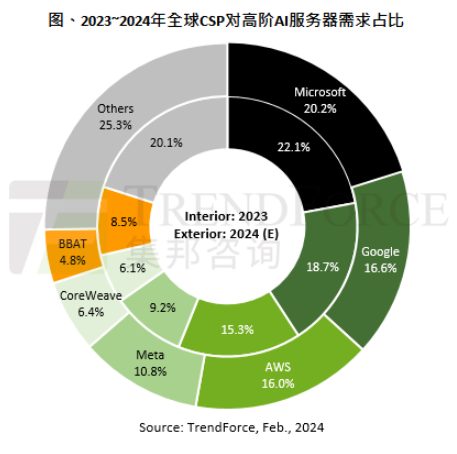

【导读】以2024年全球主要云端服务业者(CSP)对高端AI 服务器(包含搭载NVIDIA、AMD或其他高端ASIC芯片等)需求量观察,预估美系四大CSP业者包括Microsoft、Google、AWS、Meta各家占全球需求比重分别达20.2%、16.6%、16%及10.8%,合计将超过6成,居于全球领先位置。其中,又以搭载NVIDIA GPU的AI 服务器机种占大宗。

以2024年全球主要云端服务业者(CSP)对高端AI 服务器(包含搭载NVIDIA、AMD或其他高端ASIC芯片等)需求量观察,预估美系四大CSP业者包括Microsoft、Google、AWS、Meta各家占全球需求比重分别达20.2%、16.6%、16%及10.8%,合计将超过6成,居于全球领先位置。其中,又以搭载NVIDIA GPU的AI 服务器机种占大宗。

受国际形势变化影响,NVIDIA后续发展仍有挑战

NVIDIA近期整体营收来源以数据中心业务为关键,主因其GPU服务器占整体AI市场比重高达6~7成,只是后续仍须留意三大状况,可能使NVIDIA发展受限。其一,受国际形势变化影响,中国将更致力于AI芯片自主化。而NVIDIA推出的H20等中国特规方案,性价比可能不及既有的H100或H800等,中国客户采用度可能较先前保守,进一步影响NVIDIA市占率。

其二,在具规模及成本考量下,美系大型CSP业者除Google、AWS外,Microsoft、Meta等亦有逐年扩大采自研ASIC趋势。其三,来自AMD的同业竞争,AMD采高性价比策略,对标NVIDIA同级品,AMD提供仅60~70%价格,甚至代表性或具规模客户能以更低价策略方式抢进市场,预期2024年尤以Microsoft为最积极采纳AMD高端GPU MI300方案业者。

NVIDIA为维持领先,将更致力拓展多元组合产品线

NVIDIA在面临潜在隐忧下,亦更积极加速拓展其多元产品线,以应对不同客户群。2024年起将正式替换A100产品,而以价格更高的H100系列为主轴。除H100,预估自今年第二季末开始小量出货搭载更高HBM3e规格的H200产品。另预估NVIDIA未来在价格上将更积极采差别订价,H100采部分折价策略,H200应维持约H100原价格水位,以提供更高性价比方式,稳固云端CSP客户。除此之外,NVIDIA将采用NRE(一次性工程费用;Non-recurring engineering Expense)模式,与Meta、Google、AWS及OpenAI等厂商展开洽谈,并将目标扩及电信、车用及电竞客户。

此外,预期NVIDIA自2024年下半年将推出新一代B100产品,相较H系列可望在效能上又有所提升,在HBM存储器容量将高出H200约35~40%,以应对更高效能HPC或加速LLM AI训练需求。而在中低端产品上,除L40S针对企业客户做边缘端较小型AI模型训练或AI推理外,另亦规划以L4取代既有T4,作为云端或边缘AI推理应用。

值得注意的是,为避免2023年GPU供应不足问题,NVIDIA亦积极参与CoWoS及HBM等扩建产能需求,预期今年第二季在相关原厂产能逐步开出后,原交付Lead Time平均约40周也将减半,逐步去除下游供应链因GPU短缺而使AI服务器供应进度受阻问题。

免责声明:本文为转载文章,转载此文目的在于传递更多信息,版权归原作者所有。本文所用视频、图片、文字如涉及作品版权问题,请联系小编进行处理。

推荐阅读: