【导读】全球AI基础设施解决方案提供商SuperX AI Technology Limited近日正式发布SuperX GB300 NVL72机架级AI超级算力平台。该系统基于NVIDIA GB300 Grace Blackwell Ultra超级芯片,在单个液冷机架内实现了高达1.8 ExaFLOPS(每秒百亿亿次浮点运算)的FP4 AI计算性能,专为突破万亿参数大模型的训练与部署瓶颈而设计。

全球AI基础设施解决方案提供商SuperX AI Technology Limited(纳斯达克:SUPX)近日正式发布SuperX GB300 NVL72机架级AI超级算力平台。该系统基于NVIDIA GB300 Grace Blackwell Ultra超级芯片,在单个液冷机架内实现了高达1.8 ExaFLOPS(每秒百亿亿次浮点运算)的FP4 AI计算性能,专为突破万亿参数大模型的训练与部署瓶颈而设计。

一、基本特性

SuperX GB300 NVL72平台在硬件配置与性能密度上实现了多项突破:

●革命性芯片集成:采用独特的2:1组合,每个机架集成72颗NVIDIA Blackwell Ultra GPU和36颗NVIDIA Grace CPU。GPU与CPU间通过900GB/s的片间互联链路实现极致带宽。

●海量内存配置:提供总计约165TB的HBM3E显存与17TB的LPDDR5X内存,构成统一内存池,有效支撑大规模模型和键/值缓存处理。

●高速互联架构:集成4个NVIDIA NVLink连接器(1.8TB/s带宽)和4个NVIDIA ConnectX 8 OSFP端口(800Gb/s速度),确保集群内超低延迟通信。

●能效与密度平衡:采用先进液冷设计,支持24/7持续运行。平台同时依赖800伏直流电(800VDC) 供电,作为其高功率密度架构的基础。

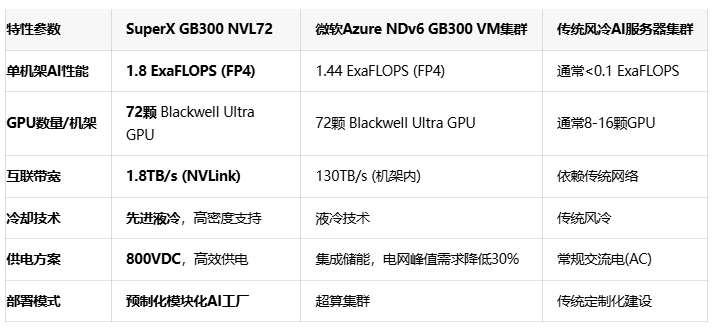

二、同类竞品对比分析

竞争分析:SuperX GB300 NVL72在单机架峰值性能上领先于同类解决方案。其1.8 ExaFLOPS的FP4算力明显高于微软Azure集群的1.44 ExaFLOPS。800VDC供电与液冷技术的结合,使其在支持超高功率密度的同时优化了能效。作为全栈式解决方案的核心,它相较于需要复杂集成工作的传统集群或Azure的集群方案,提供了更优的部署便利性。

三、应用领域

该平台主要面向需要百亿亿次级计算能力的尖端应用场景:

●超大规模与主权AI:适用于构建国家级AI基础设施、公有云服务及训练复杂多模态和大型语言模型的大型企业AI工厂。

●前沿科学研究:为物理学、材料科学和气候建模等领域的百亿亿次级科学计算提供机架级高效算力。

●工业数字孪生:满足汽车、制造和能源行业构建高保真、大规模数字孪生对Grace CPU和Blackwell Ultra GPU组合处理能力的需求。

●复杂AI推理:专为先进的AI推理、测试时间扩展以及Agentic AI和物理AI等应用优化。

四、 技术难点与应对方案

构建如此高密度的算力平台面临多重挑战,SuperX通过创新技术逐一攻克:

●散热与能耗瓶颈

挑战:传统风冷设计无法支持1.8 ExaFLOPS算力产生的巨大热量。

解决方案:采用先进液冷设计,显著提升散热效率,确保系统在超高功率密度下稳定运行。

●电力供应瓶颈

挑战:常规交流配电方案难以满足机架级海量电力需求。

解决方案:引入800伏直流电(800VDC) 供电基础设施,作为确保系统稳定性、安全性和运营可行性的基础。

●系统集成与部署复杂度

挑战:将72颗GPU和36颗CPU高效集成并快速部署极具挑战。

解决方案:将平台定位为 "SuperX预制化模块化AI工厂" 的核心引擎,与液冷系统、800VDC供电共同构成有机整体,大幅简化部署。

五、产品供货情况

根据英伟达公司的计划,GB300 NVL72 AI服务器预计将在2025年第三季度开始进入量产。

SuperX将GB300 NVL72系统定位为其全栈式"预制化模块化AI工厂"解决方案的核心,这表明客户可以通过SuperX获取包含该系统的完整解决方案。

关于该平台具体的售价和确切的交付时间,建议通过SuperX官方渠道(如销售邮箱 sales@superx.sg)进行咨询。

SuperX GB300 NVL72机架级AI平台的推出,标志着AI计算基础设施正式迈入单机架百亿亿次级(ExaFLOP级) 时代。其前所未有的算力密度、能效表现与全栈式解决方案的深度融合,为处理万亿参数模型、推动科学研究和工业创新提供了强大的基础支撑。

推荐阅读:

厚度减半性能倍增,ROHM超薄SiC MOSFET解决空间与散热难题

容量翻倍引领太空革命:Teledyne e2v DDR4实现无缝升级