【导读】Super X AI Technology Limited (纳斯达克: SUPX) 近日发布了其最新旗舰产品——SuperX XN9160-B300 AI服务器。这款服务器搭载了NVIDIA最新的Blackwell架构GPU(B300),旨在满足人工智能训练、机器学习以及高性能计算领域对可扩展性与日俱增的需求。

Super X AI Technology Limited (纳斯达克: SUPX) 近日发布了其最新旗舰产品——SuperX XN9160-B300 AI服务器。这款服务器搭载了NVIDIA最新的Blackwell架构GPU(B300),旨在满足人工智能训练、机器学习以及高性能计算领域对可扩展性与日俱增的需求。

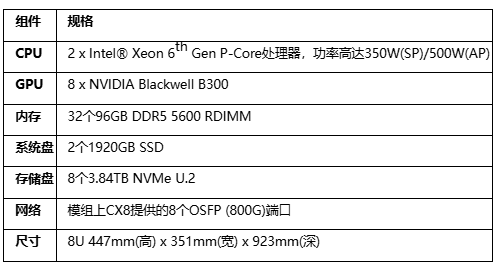

该服务器核心搭载8颗NVIDIA Blackwell B300 GPU,提供了高达2,304GB的HBM3E统一内存,并支持8个800Gb/s InfiniBand高速网络端口。其设计目标是为关键任务型数据中心环境提供卓越的计算性能与能效。

01 技术难点与行业痛点

当前AI基础设施面临着多重性能瓶颈。计算效率难以跟上模型规模扩张的速度,万亿参数级别的模型训练对算力提出了近乎苛刻的要求。

内存墙问题日益凸显,有限的显存容量无法支持大规模模型全程驻留,频繁的数据卸载与加载严重拖慢了训练与推理效率。

此外,系统扩展性和能源效率也是制约AI工厂发展的关键因素。构建大规模计算集群需要低延迟、高带宽的网络互联,同时还要控制巨大的电力消耗。

02 SuperX的创新解决方案

XN9160-B300通过多项前沿技术整合,为上述挑战提供了全面的解决方案。

●计算架构升级:采用NVIDIA Blackwell Ultra架构,其NVFP4计算能力与前代相比提升高达50%,HBM容量也同步增加50%,实现了算力与内存的双重突破。

●内存系统优化:8颗GPU提供的2304GB HBM3E统一内存构成了庞大的内存池,有效消除了内存卸载瓶颈,为大型语言模型和生成式AI的海量键/值缓存提供了充足空间。

●互联技术革新:通过8个800Gb/s InfiniBand端口和第五代NVLink互联技术,确保了GPU间无缝通信和集群扩展时的高效低延迟数据传输。

●能效管理突破:配备12个3000W 80 PLUS钛金认证冗余电源,在保证持续峰值负载稳定运行的同时,实现了极高的能源效率。

03 产品的核心作用

●XN9160-B300在AI计算生态中扮演着高性能计算枢纽的角色,为各类计算密集型应用提供了强大的算力支持。

●其大规模统一内存架构使研究人员能够训练更大规模的模型,而无需担心内存瓶颈,极大加速了AI模型的迭代周期。

●作为分布式计算的骨干节点,其卓越的网络性能使得构建万卡级别的AI工厂成为可能,为超大规模模型训练提供了基础设施保障。

04 关键产品竞争力

XN9160-B300在多个维度展现了卓越的产品竞争力:

●极致计算性能:Blackwell B300 GPU提供比前代高50%的NVFP4算力,专为下一代AI工作负载优化。

●海量内存容量:2,304GB HBM3E统一内存支持万亿参数模型全程驻留,避免内存卸载带来的性能损失。

●高速互联能力:8个800Gb/s InfiniBand端口和第五代NVLink技术,确保无阻塞的数据交换和GPU通信。

●稳健电源设计:12个3000W钛金级冗余电源,为系统持续高负载运行提供充足电力保障。

●全面生态兼容:支持双Intel Xeon 6处理器、32个DDR5 DIMM插槽及多个PCIe Gen5 x16扩展槽,为多样化工作负载提供平台支持。

05 市场竞争定位分析

通过与市场同类产品对比,XN9160-B300在计算性能、内存容量和网络带宽等关键指标上均表现出明显优势。

其采用的Blackwell Ultra架构实现了跨越式的性能提升,而HBM3E内存和高速互联技术则为其在大规模模型训练场景中奠定了领先地位。

06 实际应用场景

●超大规模AI工厂:适用于构建和运营万亿参数基础模型及高并发AI推理引擎,满足云服务提供商和大型企业的算力需求。

●科学研究与模拟:支持百亿亿次级别科学计算,应用于气候建模、药物发现和数字孪生等前沿科研领域。

●金融分析与决策:服务于实时风险建模、高频交易模拟及金融领域大型语言模型应用,提供超低延迟计算能力。

●生物信息学与医疗:加速海量基因组测序、药物发现流程和蛋白质结构预测,缩短科研到临床的转化周期。

●全球系统建模:为国家气象机构和政府部门的全球气候预测与灾害模拟提供极致算力支持。

07 产品供货情况

根据公开信息,SuperX XN9160-B300 AI服务器已正式发布。

公司近期宣布计划在日本建立其首个区域供应中心,目标达到10,000台服务器的产能,以增强其全球供应链能力。

XN9160-B300的推出标志着AI服务器领域进入了新的性能层级,其算力与内存容量的双重提升为下一代AI应用提供了坚实的基础设施支持。

随着AI模型规模的不断扩大,像XN9160-B300这样兼具高性能、高可扩展性和高能效的服务器解决方案,将成为推动AI技术创新和产业应用的关键力量。

推荐阅读:

破解散热难题:Advanced Energy新一代转换器实现效率与密度双突破

Holtek新品MCU:为感烟报警器注入万年历与蜂鸣器驱动双动力

专为OBC/PDU设计:Littelfuse AEC-Q200保险丝实现10kA高分断能力

ROHM创新肖特基二极管RBE01VYM6AFH:优化ADAS摄像头模块保护性能