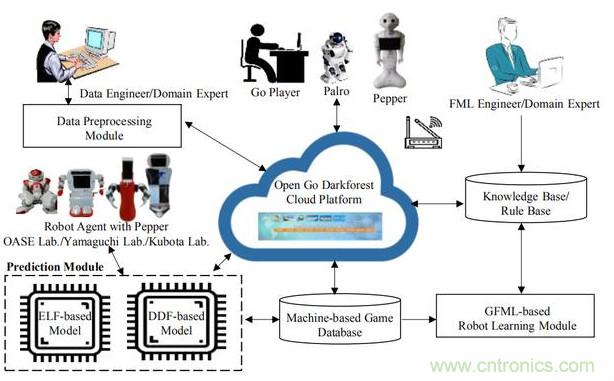

【导读】4月10日早间消息,据彭博社报道,高通宣布将提供一款可以加速人工智能处理速度的新型数据中心芯片。高通高管基斯·克里辛(Keith Kressin)表示,该公司将使用其在移动领域的技术专长,并借助其利用最新制造技术设计芯片的能力。而这款芯片的关键特征在于能耗效率。

这个市场到2025年的规模预计可达170亿美元。高通公司正在将其在小型低功耗移动设计方面的专业知识转向数据中心,宣布推出一款新的AI加速芯片,可帮助解决数据中心运营商日益烦恼的空间和功率限制问题。

由于智能手机增速放缓、竞争加剧和法律诉讼增多,高通已经陷入增长停滞。为了应对这一状况,该公司开始寻找新的市场来扭转局势。图像和语音识别以及数据决策业务都在快速增长,并且拓展了芯片的能力范围。

半导体企业都在为谷歌、亚马逊和Facebook努力优化传统芯片或提供全新的方法,这些云计算提供商甚至开始自主设计芯片。

Facebook产品经理乔·斯比萨克(Joe Spisak)表示,该公司每天要进行200万亿次预测。如此庞大的工作量导致数据中心难以满足日益增长的需求。这也凸显出开发新型解决方案的迫切需求。

作为数据中心处理器市场的主导企业,英特尔已经收购了一些开发另类芯片的小型企业,希望帮助其处理人工智能任务。该公司还增加了其他一些功能,加强数据处理能力。英伟达也组建了庞大的业务,为数据中心提供图形处理芯片。

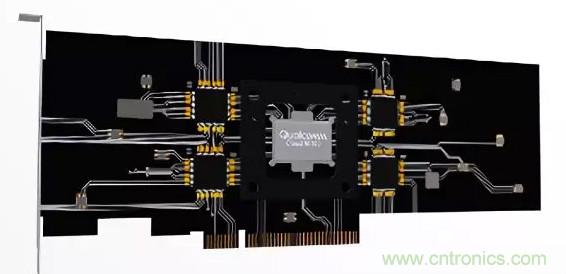

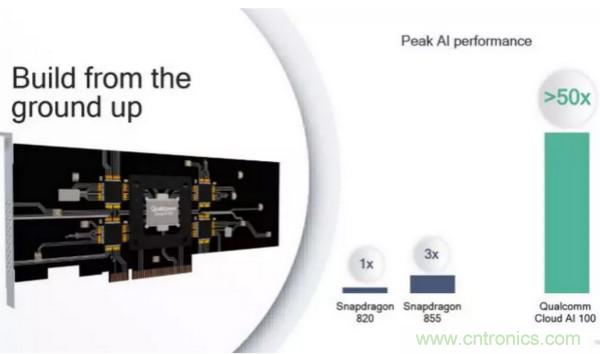

克里辛表示,高通将在今年晚些时候披露关于其Cloud A1 100芯片的更多细节。这款芯片的目标是根据数字化的语音或图片数据流分析来制定决策。他表示,这不是手机处理器的简单改版,其人工智能处理能力达到该公司旗舰手机芯片的50倍。该产品将于2020年开始生产。

“随着机器学习功能被整合到更多的云应用程序中,神经网络推理加速的市场将会起飞,”Tirias Research首席分析师Kevin Krewell在电子邮件中告诉媒体。 “为了更容易融入现有的机架式服务器[在数据中心],这些新的推理卡需要低功耗和紧凑的尺寸。高通公司利用其在低功耗移动设计方面的经验,构建一个非常节能的加速器,一个非常有竞争力的软件栈。“

当然,高通公司的业务是为当今许多智能手机开发技术和芯片。这些设备需要使用功率不大的微型芯片 - 这些属性越来越受到数据中心运营商的青睐。

此外,十多年来,高通一直致力于将AI功能插入其手机芯片中,现在它正在努力利用这些努力为数据中心市场推出新的AI加速芯片。正如Tirias的Krewell指出的那样,高通公司新的Cloud AI 100芯片将与Nvidia的Tesla T4 PCIe卡和Intel的Nervana芯片以及Habana Labs等初创公司的产品竞争。

高通公司的新数据中心芯片组是该公司推动进入更广泛新增长领域的一部分 - 在高通公司未能完善其与恩智浦的合并计划之后,这一努力受到了新的重视。高通一直在押注这项交易,将其可寻址市场扩展到更广泛的汽车行业,现在高通正在努力通过Cloud AI 100这样的有机努力,推动进入正在逐渐冷却手机领域以外的新业务。

至于Cloud AI 100,高通公司称其产品的性能比当今数据中心使用的CPU,GPU和/或FPGA的组合高出10倍。该公司补充说,到2025年,这类芯片的市场可能增长到170亿美元。该公司称该芯片采用7nm工艺,可支持AI系统,包括PyTorch,Glow,TensorFlow,Keras和ONNX。

在其Cloud AI 100发布中,高通公司推出了微软和Facebook的支持声明。虽然两家公司都没有宣布正式购买Cloud AI 100的协议,但高通公司正在利用其在市场上的重要性,为其进入数据中心行业提供更多合理性。

Cloud AI 100芯片是今天高通公司发布的一系列以AI为重点的公告的一部分。该公司还宣布推出Snapdragon系列手机芯片的几款新产品,包括新的人工智能,游戏,相机和性能改进。

昨天在旧金山举办的年度 Qualcomm AI Day 大会上,高通发布了三款面向智能手机、平板电脑和其他移动设备的新系统芯片。此外,更重磅的是,高通还宣布了一款专为边缘计算设计的新产品:Qualcomm Cloud AI 100。高通 Cloud AI 100 采用 7nm 工艺,具有高度可扩展性、专为 AI 推理设计,将于 2020年正式推出产品,样片将在今年晚些时候推出。

虽然高通尚未公开芯片性能或架构方面的细节,但它声称,Cloud AI 100 的性能比目前业界最先进的 AI 推理解决方案高出 10 倍以上。Cloud AI 100 集成了一系列开发工具,包括编译器、调试器、分析器、监视器、服务、芯片调试器和数字转换器。此外,Cloud AI 100 还致力于支持领先的软件堆栈,包括 ONNX、Glow 和 XLA,以及各种机器学习框架,包括谷歌的 TensorFlow、Facebook 的 PyTorch、Keras、MXNet、百度的 PaddlePaddle 和微软的 Cognitive Toolkit。

高通估计 Cloud AI 100 的峰值性能能达到骁龙 855 和骁龙 820 的的 3 至 50 倍。

高通声称,与传统的现场可编程门阵列 (FPGA) 相比,Cloud AI 100 在推断任务方面的平均速度要快 10 倍左右。此外,以高性能芯片常用的一个性能指标 —— 每秒 tera 操作(TOPs) 来衡量的话,Cloud AI 100 的运算速度可以 “远远超过”100 TOPs。(相比之下,骁龙 855 最快只有约 7 TOPs。)

高通设想通过基于台积电 7nm 节点构建的 Qualcomm Cloud AI 100,为 5G 提供更低的延迟,并为云和边缘带来更高的性能和效率。

“FPGA 或 GPU 通常可以更有效地进行 AI 推理处理…… 因为 GPU 是更并行的,而 CPU是更串行的,并行芯片更适合 AI 处理。” 高通产品管理高级副总裁 Keith Kressin 解释说:“不过,GPU 更多的是为图形设计的,如果你从头开始设计一个芯片来加速 AI,可以得到显著的改进。从 CPU 到 FPGA 或 GPU 都有数量级的改进。但定制 AI 加速器能提供再一个数量级的改进。”

挑战华为、英特尔等,AI推理芯片竞争激烈

在高通进军云计算之前,其主要竞争对手华为发布了据称是业界性能最高的基于 Arm 的处理器 “鲲鹏 920”。在 SPECint(一个由 12 个程序组成的基准测试套件,用于测试整数性能) 中,该芯片的得分超过了 930 分,比行业基准高出近 25%,而功耗比 “行业现有厂商提供的” 低 30%。

华为不是高通唯一的对手。

今年 1 月在拉斯维加斯举行的消费电子展上,英特尔详细介绍了即将推出的 Nervana 神经网络处理器 (NNP-I)。据报道,该处理器的 AI 训练性能将达到竞争显卡的 10 倍。

谷歌去年推出了专用推理芯片 Edge TPU;阿里巴巴也在去年 12 月宣布,计划在今年下半年推出首款自主研发的 AI 推理芯片。

在 FPGA 方面,亚马逊最近推出了自己的 AI 云加速芯片 ——AWS Inferentia。

微软也在 Project Brainwave 中预报了一个类似的平台。

今年 3 月,Facebook 发布了用于 AI 推理的服务器芯片 Kings Canyon。

就在本月,英特尔宣布推出一系列芯片组 ——Agilex,针对人工智能和大数据工作负载进行了优化。

但高通对 Cloud AI 100 的性能优势颇有信心,认为它将在深度学习芯片组市场上占据优势,预计到 2025 年,该市场规模将达到 6630 万美元。

“很多人把网络硬件放在云端,就像一个内容传输网络,用于不同类型的处理,无论是云端游戏,还是人工智能处理。这是另一个关键趋势。高通有机会从终端用户的输入技术一路参与,一直到云端。”Kressin 说。

高通的另一个潜在优势是什么呢?生态系统的支持。去年 11 月,高通向一家专注于edge AI 和 on-device AI 的初创基金提供 1 亿美元,特别投入于自动驾驶汽车、机器人、计算机视觉和物联网领域。去年 5 月,高通与微软合作,为在其许多片上系统芯片中嵌入的 AI 加速器创建了一个 vision AI 开发工具包。

“就市场规模而言,推理正在成为芯片领域的一个相当大的市场,”Kressin 说:“随着时间的推移,我们预计推理的规模 —— 从 2018 年至 2025 年大约会增长 10 倍。我们非常有信心成为这一领域的领导者。”

推荐阅读: